Autor | Lucía Burbano

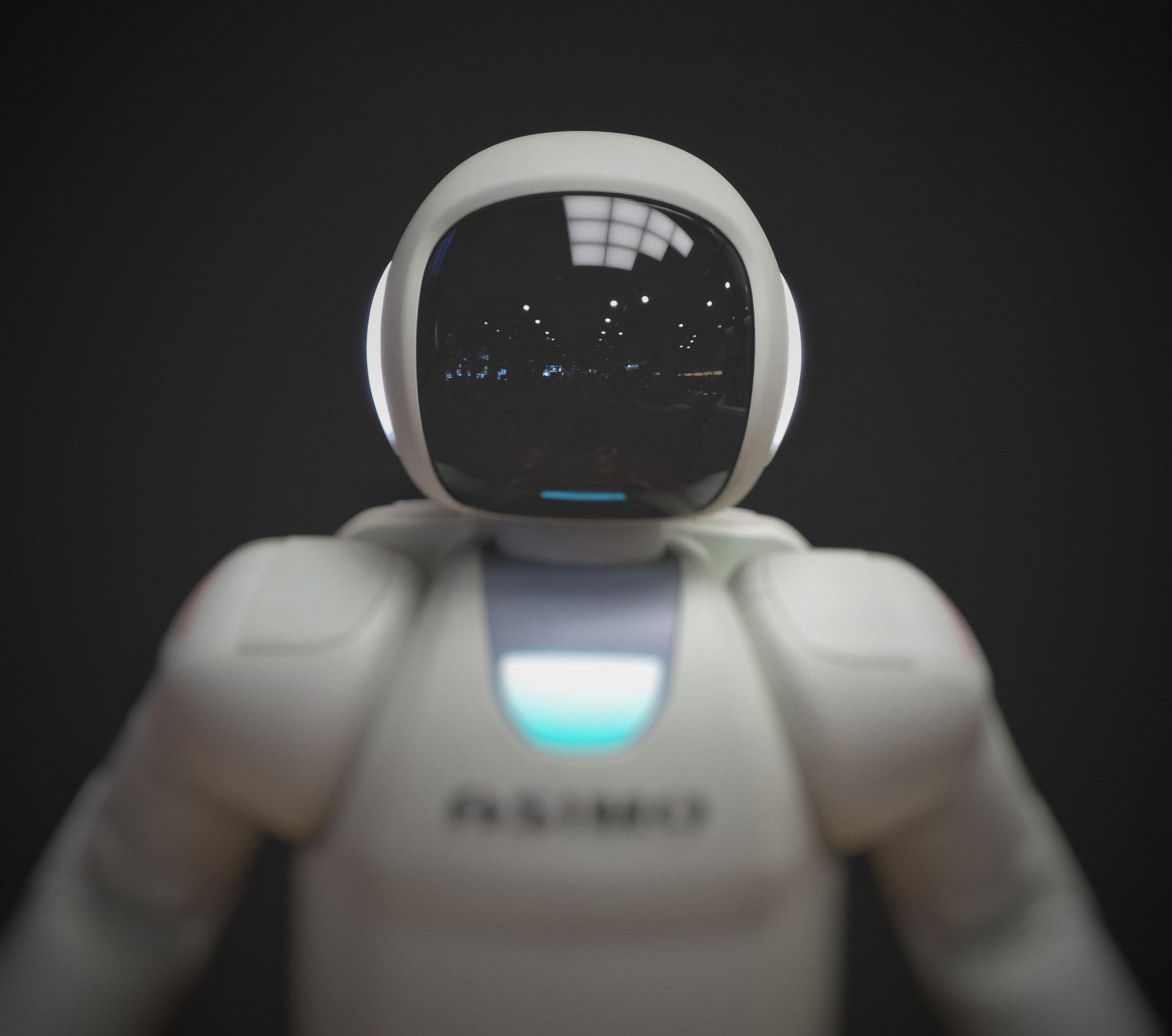

A partir del aprendizaje basado en datos públicos sobre delitos violentos y contra la propiedad, científicos de la Universidad de Chicago han desarrollado un nuevo algoritmo que puede predecir los futuros delitos con una semana de antelación y con una precisión del 90%. Aquí surgen algunas dudas, pero sobre todo una, ¿será la inteligencia artificial la nueva herramienta de la justicia?

¿Qué es la justicia predictiva?

A pesar de sonar extremadamente moderna, la jurimetría o justicia predictiva es un concepto que apareció en 1949 a manos de Lee Loevinger, un jurista estadounidense que planteó utilizar la estadística y las probabilidades matemáticas como respuesta a ciertas cuestiones legales. Resumió su idea en un artículo que publicó aquel año en el Minnesota Law Review.

Evidentemente, hace más de setenta años no existían ni los algoritmos ni la Inteligencia Artificial (IA), que hoy puede imitar procesos cognitivos y tomar decisiones y resolver problemas analizando millones de datos. Pero el debate ya estaba servido.

IA para predecir un crimen

Regresando al ámbito jurídico, la Inteligencia Artificial permite, por un lado, reducir el tiempo que dedica un profesional del Derecho a preparar un caso al analizar millones de decisiones judiciales similares a las que se enfrenta.

Por el otro, y enfocado en la justicia predictiva, los algoritmos que utiliza el estudio publicado por Victor Rotaru, Yi Huang, Timmy Li, James Evans y Ishanu Chattopadhyay, emplea datos históricos de la ciudad de Chicago sobre dos grandes categorías de sucesos denunciados: delitos violentos (homicidios y agresiones) y delitos contra la propiedad (robos, hurtos y robos de vehículos).

Eligieron estos datos porque cuentan con mayores probabilidades de que sean denunciados a la policía en zonas urbanas donde existe desconfianza y falta de cooperación entre los ciudadanos y las fuerzas del orden. Además de en Chicago, este sistema predictivo ya se ha probado en las ciudades de Atlanta, Austin, Detroit, Los Ángeles, Filadelfia, Portland y San Francisco.

China, Israel, Reino Unido… el mapa de la justicia predictiva

También en Estados Unidos, la start-up Predpol nació en 2012 como un proyecto de investigación realizado conjuntamente entre el departamento de policía de Los Ángeles y UCLA. Bill Bratton, el comisario de entonces, quería encontrar una forma de utilizar los datos de la COMPSTAT, herramienta de gestión organizacional de la policía, para que facilitara recomendaciones predictivas sobre dónde y cuándo podrían producirse nuevos delitos.

Desde entonces, esta herramienta de justicia predictiva protege a una de cada 33 personas en Estados Unidos, según afirman en su web. En Pensilvania, por ejemplo**, afirman que los robos se han reducido un 23% gracias a este sistema predictivo.**

Otro país que utiliza tecnologías predictivas en su sistema judicial es China. Desde 2017, la compañía de inteligencia artificial Megvii trabaja en una IA que analiza horas grabadas en vídeo cámaras buscando patrones inusuales que pudieran ser ilegales para avisar a la policía.

Y existen más ejemplos. El programa Eurocop, que desarrolla la Universidad de Castellón en España, elabora un mapa de previsión de lugares y horas concretas de una ciudad donde puede suceder un delito.

La Universidad de Cambridge cuenta con el proyecto de inteligencia predictiva Hart; Italia, XLAW; Alemania, Precobs; Japón, Vaak e Israel, Cortica, que también se utiliza en la India.

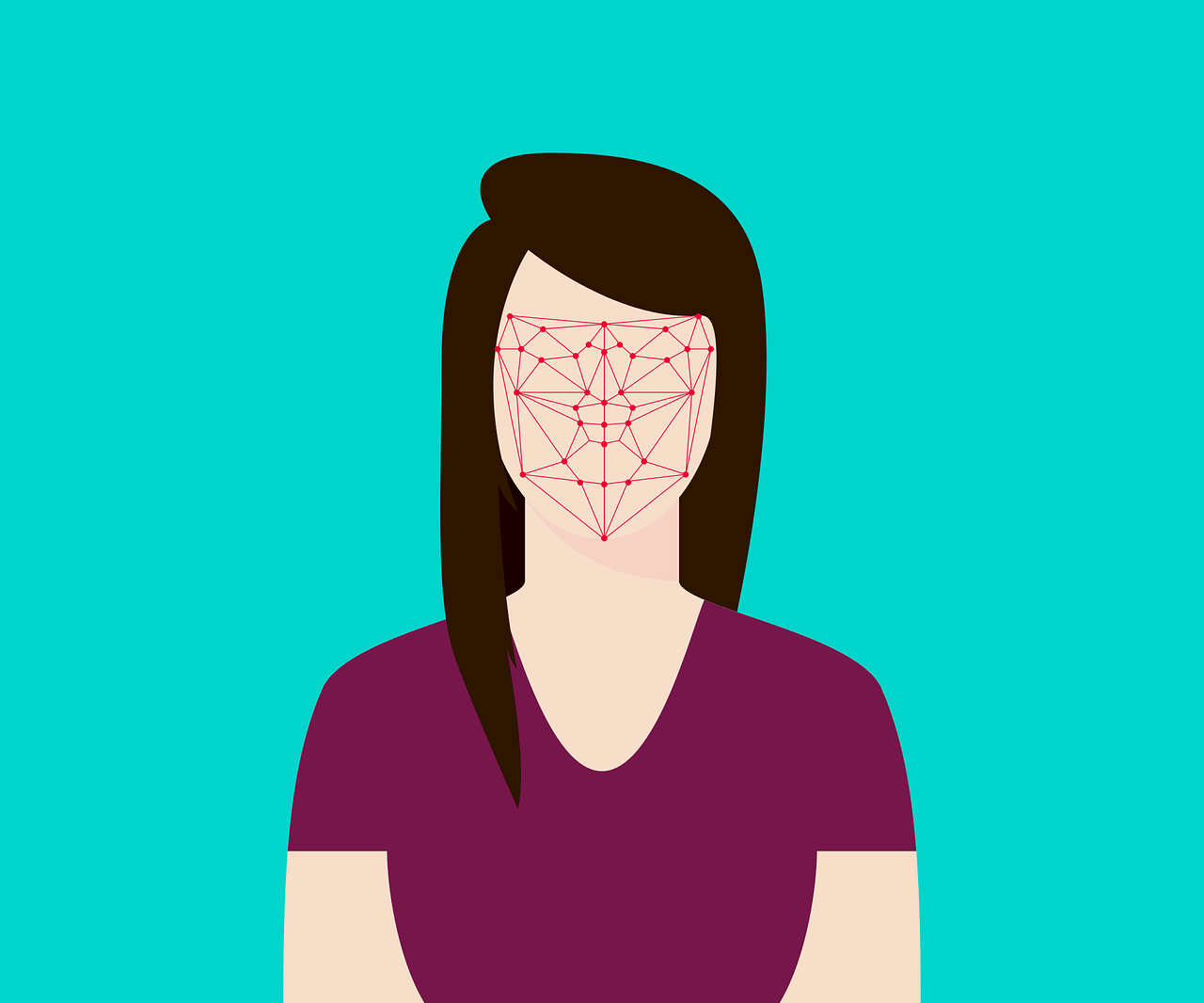

Discrepancias sobre el uso de IA en la justicia

No todo el mundo está conforme con el uso de la IA en los departamentos policiales. Liberty Human Rights del Reino Unido, expresó su disconformidad alegando que el uso de estos programas es "discriminatorio" y "peligroso".

"Nuestra investigación ha revelado que al menos 14 fuerzas policiales del Reino Unido han utilizado o pretenden utilizar algoritmos informáticos discriminatorios para predecir dónde se cometerán los delitos y por quién. Los programas de predicción no son neutrales. Están entrenados por personas y se basan en datos policiales existentes, por lo que reflejan patrones de discriminación y los incorporan a la práctica policial", argumentan.

Además, alertan que el público recibe "muy poca información" sobre cómo los algoritmos predictivos llegan a sus decisiones, incluso en el caso de la policía. "Esta falta de transparencia y comprensión significa que estos programas no pueden ser examinados adecuadamente".

Por último, piden "a las fuerzas policiales que pongan fin al uso de estos programas peligrosos y discriminatorios".

El debate está servido.

Fotografías | Unsplash/Possessed Photography, Unsplash/Tingey Injury Law Firm